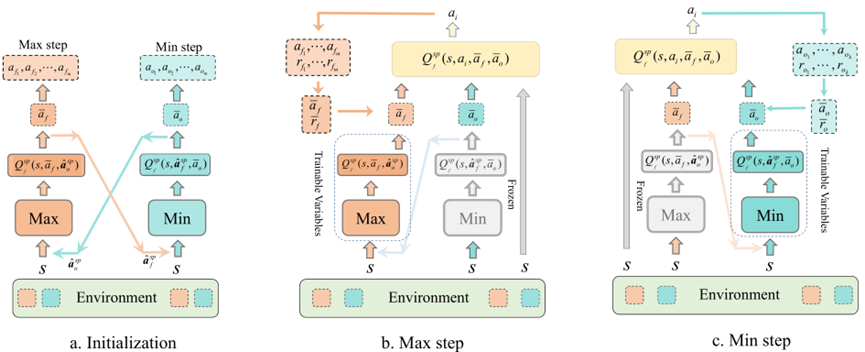

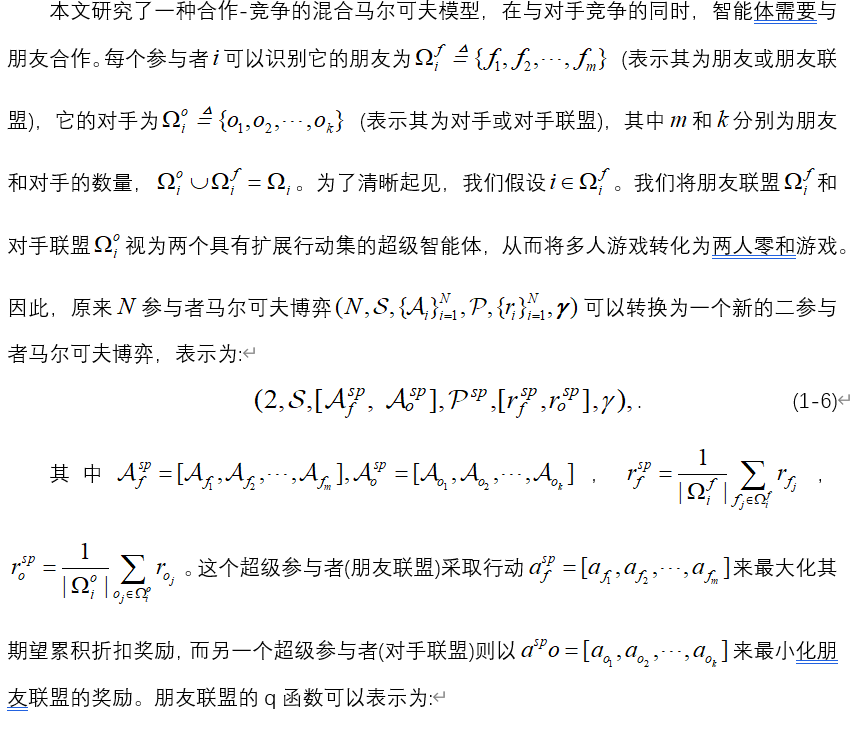

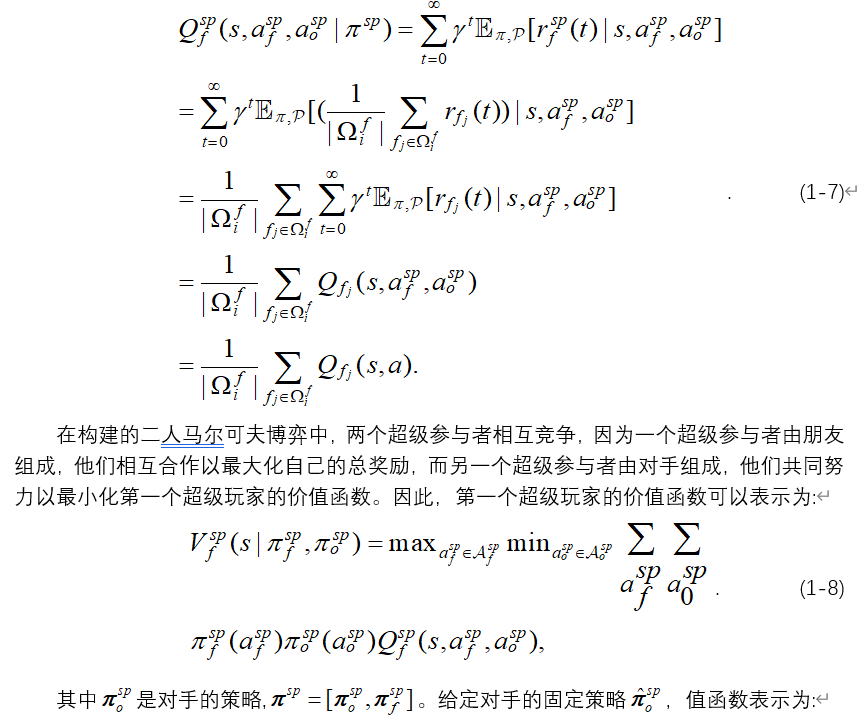

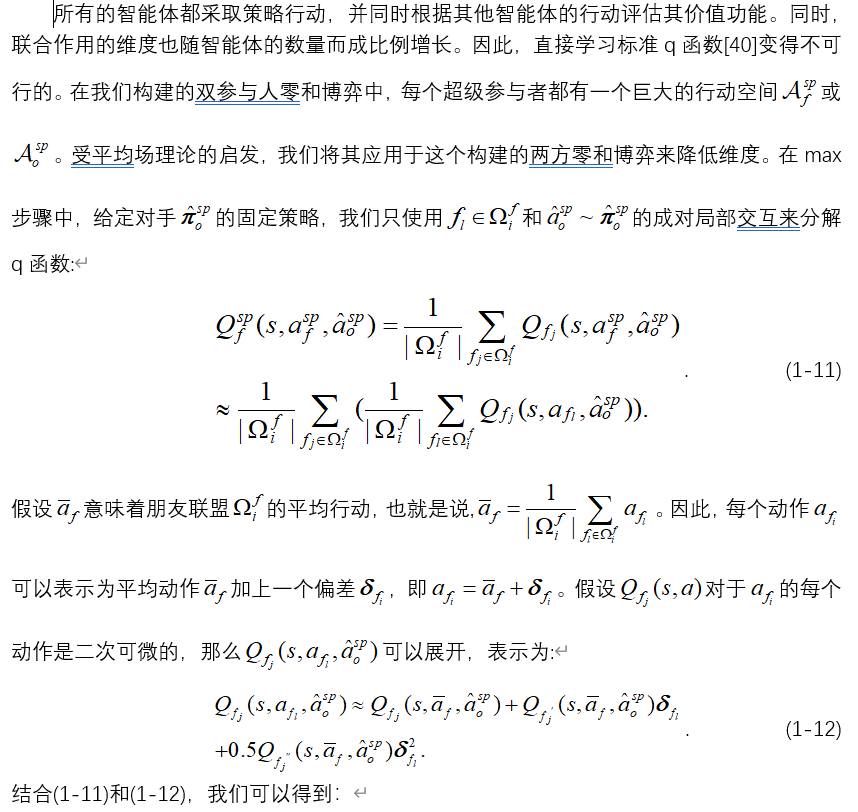

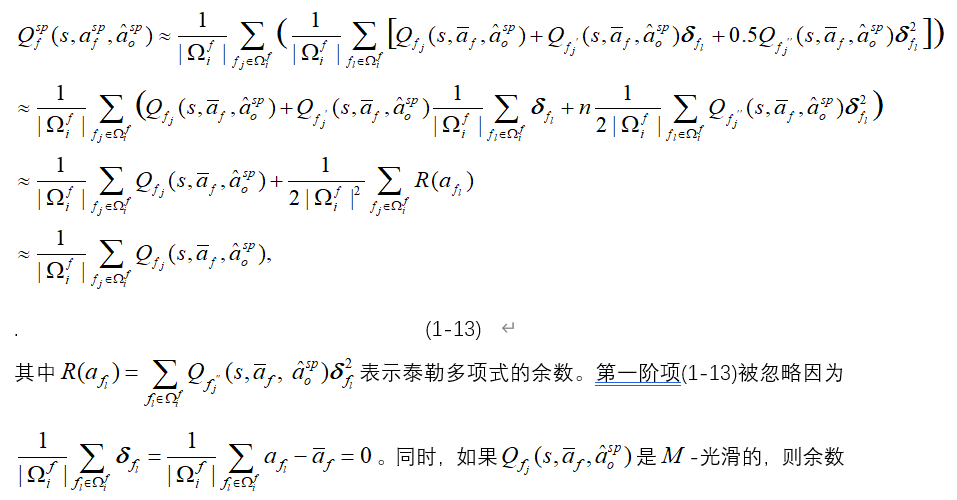

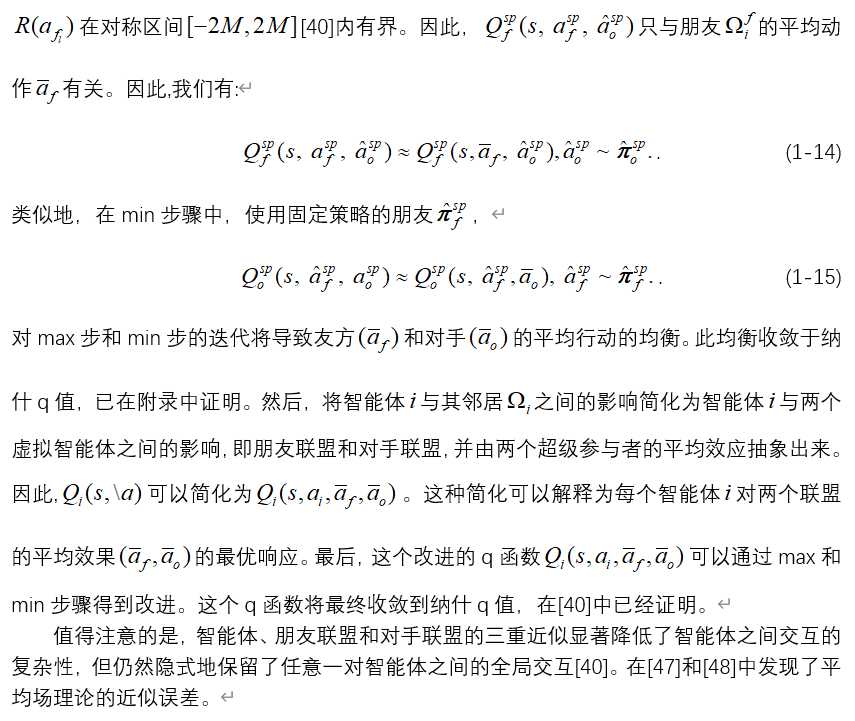

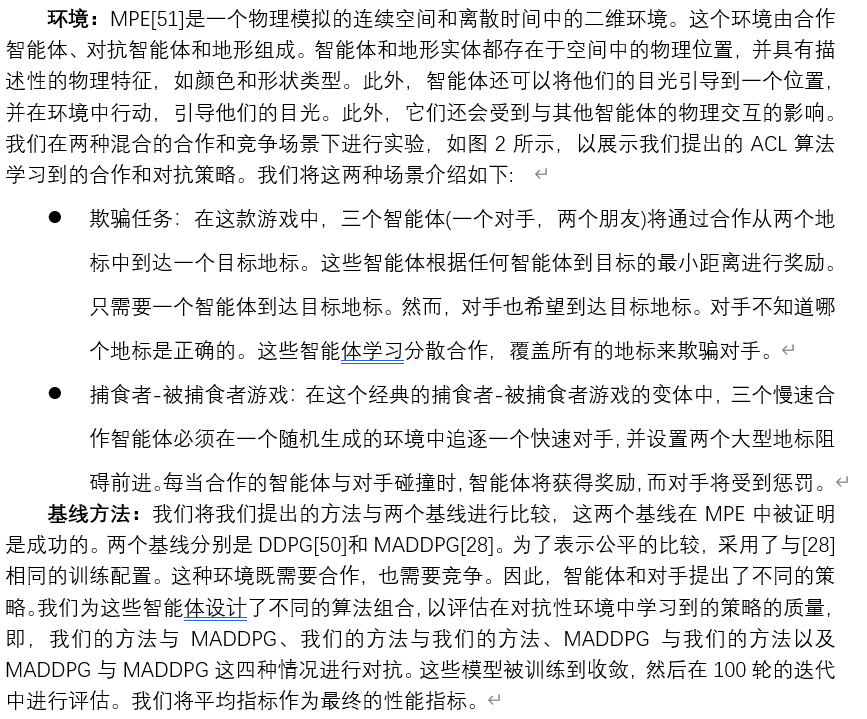

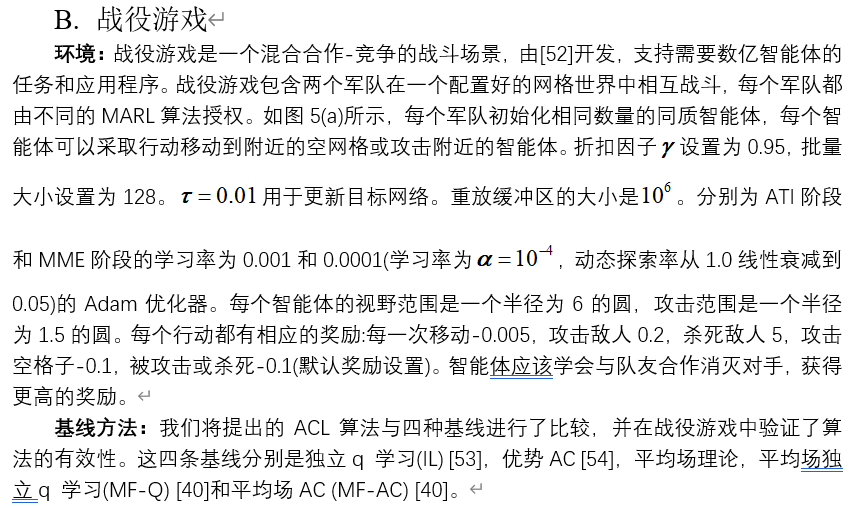

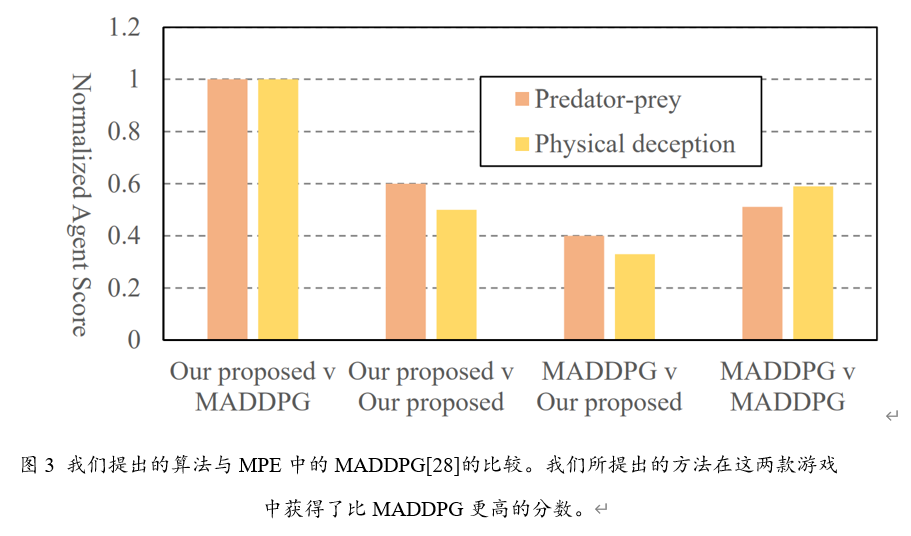

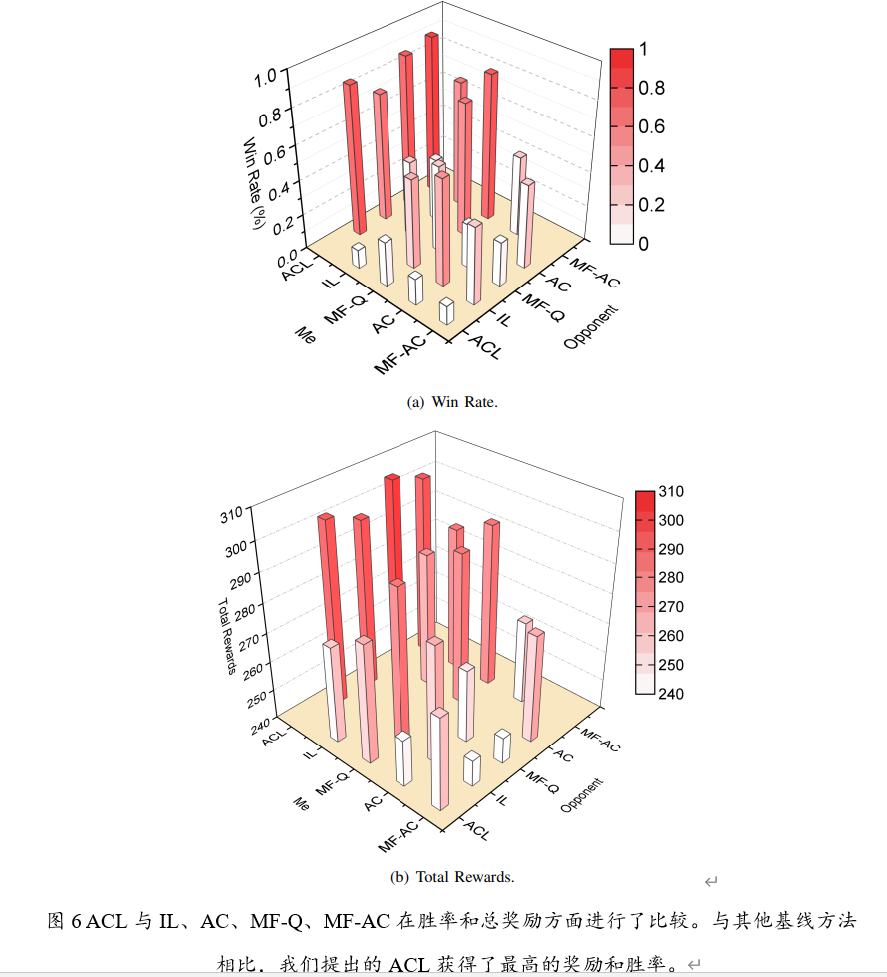

基于平均场理论的多智能体对抗性协作学习 刘奕琳 2022-07-07 21:41 No Comment 4188次浏览 2022年发表在IEEE Transactions on Cybernetics,提出了一种在混合合作-竞争环境下的对抗性合作学习方法,根据平均场理论,将互动简化为单个主体与朋友和对手的平均效应之间的互动。利用神经网络学习这两个联盟的最优平均效果,通过对抗性的最大和最小步进行训练。 <!--more--> **[· 论文摘要](#1) [· 核心算法](#2) [· 对比分析](#3) [· 原文信息](#4)** <p id = "1" ></p> ## **论文摘要** 多智能体强化学习(MARL)近年来引起了学术界和实践界的广泛关注。智能体相互作用的指数增长带来的维度诅咒和同步学习导致的非平稳环境等核心问题阻碍了MARL的大规模扩散,这些问题随着智能体数量的增加而恶化。为了解决这些挑战,我们提出了一种在混合合作-竞争环境下的对抗性合作学习方法,利用敌友q学习和平均场理论。首先,我们将智能体 的邻居视为两个联盟(分别是智能体 的朋友联盟和对手联盟),并将马尔可夫博弈转化为具有扩展行动集的两方零和博弈。根据平均场理论,将互动简化为单个主体与朋友和对手的平均效应之间的互动。利用神经网络学习这两个联盟的最优平均效果,通过对抗性的最大和最小步进行训练。在最大步中,基于对手的固定策略,我们优化朋友的平均动作以最大化他们的奖励。在最小步中,朋友的策略被固定,对手的平均行动被训练成最小化朋友的奖励。我们证明了这两个步骤收敛于一个纳什均衡。然后,利用另一个神经网络来学习每个智能体对平均效应的最佳响应。最后,采用对抗性的最大和最小步长来共同优化两个网络。在两个平台上的实验证明了我们的方法的学习有效性和强度,特别是在多个智能体的情况下。 <p id = "2"></p> ## **核心算法** 算法的网络结构如下图:  ### 1. 构建双人零和博弈    ### 2. 平均场理论进行估计    <p id = "3"></p> ## **对比分析** 进行了如下的两组实验:   实验结果如下:   <p id = "4"></p> ## **原文信息** **论文引用:** Luo G, Zhang H, He H, et al. Multiagent adversarial collaborative learning via mean-field theory[J]. IEEE Transactions on Cybernetics, 2020, 51(10): 4994-5007. **论文原文:** https://ieeexplore.ieee.org/abstract/document/9238422/